Processi stocastici, stazionarietà ed ergodicità e densità spettrale di potenza

Template:Risorsa Un processo casuale potrebbe essere, per esempio, quando si acquisisce un segnale con un oscilloscopio collegato ad un generatore di forme d'onda; la sinusoide generata sarà , dove è una variabile casuale.

Processi casuali

Un processo casuale è una collezione di variabili casuali indicizzate dal tempo . Quindi, è una variabile casuale definita nello spazio di probabilità . Fissato l'istante temporale , si ha una funzione misurabile

che parte dallo spazio per giungere allo spazio . È possibile indicare un processo stocastico anche con la notazione

dove è misurabile rispetto ad .

Se , il processo si dice a tempo continuo; al contrario, se , allora il processo si dice a tempo discreto.

Se fissiamo , allora è una funzione del tempo, altrimenti detta realizzazione.

Caratterizzazione statistica del processo

Realizzazioni

Fissato a scelta, disegnamo una realizzazione del processo nel tempo.

Variabili casuali

Fissato il tempo, si ha una variabile casuale osservando varie realizzazioni del processo, in quel preciso istante temporale.

Densità di probabilità

Per il calcolo della densità congiunta del second'ordine, è necessario fissare due istanti temporali .

Caratterizzazione statistica di un processo

Si prendano diversi istanti di tempo . Si definisce la quantità

come la probabilità finito-dimensionale del processo . Dato che è una variabile casuale, la quantità appena definita è pari alla probabilità congiunta di un vettore n-dimensionale di variabili casuali, con .

In modo equivalente ai vettori di variabili casuali, un processo è caratterizzato dalla densità di probabilità congiunta, che si indica con

Dalla congiunta è sempre possibile ottenere le marginali, che possono essere pensate come delle congiunte di ordine inferiore.

Ergodicità dei processi casuali

Supponendo di avere un processo stocastico stazionario (in senso lato), andiamo a cercare di dedurre qualcosa dalla sua densità di probabilità generando una realizzazione nel tempo. Vedremo che se il processo è ergodico, medie d'insieme e temporali coincidono.

Consideriamo un processo , con definito sullo spazio di probabilità . Fissato l'esito , otteniamo una realizzazione . Vogliamo capire se (e sotto quali condizioni) è possibile determinare delle caratteristiche di , osservando un'unica realizzazione.

Se il processo è stazionario in senso lato, allora

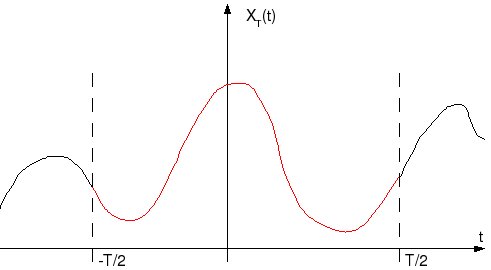

Consideriamo la realizzazione in una finestra .

File:TFA realizzazione per ergodicita processi.jpg

La grandezza è una stima, si riferisce ad una particolare realizzazione .

Il teorema di Slutsky permette di facilitare il compito di verifica dell'ergodicità di un dato processo. Una condizione sufficiente (ma non necessaria) affinché sia ergodico è che

In modo alternativo, si può definire l'ergodicità del processo nel seguente modo:

- se è WSS di prim'ordine, allora

- Di conseguenza, si ha che è un processo ergodico rispetto al valor medio se è verificato

- Questa si dice convergenza in probabilità, o convergenza qox (per quasi ogni ). Se è continuo, possono esistere alcuni per cui non è verificata l'equazione, ma se questi punti sono isolati (concetto di qox), allora si ha comunque la convergenza cercata. La probabilità di un particolare , infatti, è infinitesima (nel caso di processi a tempo continuo, lo stesso non vale per processi a tempo discreto).

- WSS del second'ordine è ergodico rispetto alla sua funzione di autocorrelazione se vale

- Anche questa è una convergenza in probabilità, con

- che è l'autocorrelazione temporale del processo. In termini pratici, questo equivale a dire che

dove è la solita stima della funzione di autocorrelazione e è l'autocorrelazione d'insieme, che viene a coincidere con l'autocorrelazione temporale .

Densità spettrale di potenza

Consideriamo il processo . Fissato otteniamo una realizzazione che in generale rappresenta un segnale di potenza non periodico, quindi non è possibile dare una caratterizzazione frequenziale attraverso la trasformata di Fourier (in modo diretto). È tuttavia possibile caratterizzare i processi casuali almeno in termini di spettro di potenza. A questo proposito, consideriamo il processo

Limitatamente al periodo , il segnale diventa ad energia finita,

quindi si ha anche lo spettro di potenza finito,

Proprietà della densità spettrale di potenza

- 1.

- 2. è detto periodogramma del processo

- 3. Teorema di Wiener-Kinchine; se un processo stocastico è stazionario in senso lato (del second'ordine), allora si ha

- 4. Se è a valori reali, allora è pari, di conseguenza si ha che

- 5. che è la potenza del processo

- 6.

Descrizione congiunta dei processi stocastici

Consideriamo e due processi definiti sullo stesso spazio di probabilità . Se volessimo caratterizzare congiuntamente i due processi, dovremmo fare

e questo dovrebbe valere:

Questa è la densità congiunta finito-dimensionale; passando invece alle descrizioni sintetiche, si possono identificare:

- i valori medi

- le funzioni di autocorrelazione

- le funzioni di covarianza

- le funzioni di crosscorrelazione

- le funzioni di crosscovarianza

Nel caso particolare in cui i processi siano delle variabili casuali gaussiane, allora si ha che

mentre i tutti gli altri casi si ha

Nel caso di processi congiuntamente stazionari in senso lato (WSS), si ha

e vale

Inoltre, vale